Important: The GCConnex decommission will not affect GCCollab or GCWiki. Thank you and happy collaborating!

Contrôle de la qualité des données CTP assisté par l’IA

(English: AI-Assisted Quality Control of CTD Data)

Dans le cadre de la série d’outils d’intelligence artificielle relatifs à la conductivité, la température et la profondeur (CTP) que produit le Bureau de l’intendant en chef des données, nous élaborons un modèle pour aider à repérer et à supprimer les analyses de mauvaise qualité pendant le processus de contrôle de la qualité des données CTP. À l’aide de la combinaison d’un modèle de mélange gaussien (GMM) pour regrouper les analyses de la CTP dans des groupes ayant des propriétés physiques semblables et de perceptrons multicouches pour classer les analyses dans chaque groupe, nous sommes en mesure de signaler automatiquement les analyses de mauvaise qualité à supprimer avec un degré élevé d’exactitude. Grâce au déploiement du modèle en tant que point d’extrémité en ligne en temps réel et au soutien de la communication du modèle au moyen d’un programme côté-client, nous avons réussi à intégrer un modèle expérimental au processus opérationnel du client dans un environnement de mise à l’essai sur le terrain. La poursuite de ce travail visera maintenant à intégrer le modèle dans un environnement de production pour un usage régulier dans le cadre du processus de contrôle de la qualité.

Objectifs du cas d’usage

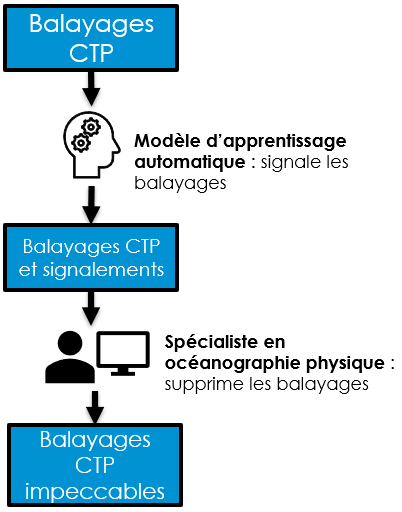

Le processus de contrôle de la qualité des données CTP exige beaucoup de temps. Un océanographe effectue une inspection visuelle pour repérer les analyses de mauvaise qualité dans chaque profil CTP à l’aide d’un logiciel d’édition graphique. Étant donné que la tâche exige une inspection minutieuse des données et des profils CTP recueillis au cours d’une année, ce travail demande beaucoup de temps et d’efforts. Pour alléger ce fardeau, nous avons produit un outil d’intelligence artificielle capable de signaler les analyses de la CTP de mauvaise qualité de sorte que ces indicateurs puissent être affichés dans le logiciel d’édition graphique pour l’océanographe. Cela permet d’accélérer la tâche en fournissant une référence rapide pour les secteurs des profils CTP où une attention est requise. En fournissant des indicateurs pour la prise de décisions assistées plutôt qu’en utilisant le modèle pour la prise de décisions entièrement automatisée, nous préservons la capacité de l’océanographe d’avoir recours à son expertise dans le domaine pour prendre les meilleures décisions possibles. À mesure que le modèle prend de l’expérience et que son rendement s’améliore, nous pouvons explorer des options pour accroître le degré d’automatisation.

- Tâche d’apprentissage machine : Signaler à l’avance les analyses à supprimer au moment du contrôle de la qualité des données CTP.

- Valeur opérationnelle : Les analyses signalées permettent à l’océanographe de concentrer rapidement son attention sur les secteurs essentiels, ce qui réduit le temps et l’effort requis pour supprimer les analyses.

- Mesures du succès :

- Exactitude des prévisions du modèle

- Commentaires des clients sur l’accélération du contrôle de la qualité

- Objectifs ultimes :

- Atténuation de l’incertitude dans les décisions humaines

- Automatisation partielle ou complète des suppressions d’analyses

Pipeline d’apprentissage automatique

Le pipeline d’apprentissage automatique comprend trois étapes principales, soit la préparation des données, le partitionnement des données au moyen d’un modèle de mélange gaussien (GMM) et la classification des données au moyen d’un perceptron multicouche.

La préparation des données couvre les tâches d’apprentissage machine standard que sont le nettoyage des données, l’ingénierie des caractéristiques et la mise à l’échelle. L’ingénierie des caractéristiques sert à extraire les renseignements les plus pertinents des données pour une utilisation ultérieure dans la tâche de classification. Le perceptron multicouche classe chaque analyse de la CTP indépendamment en fonction de ses caractéristiques. Cependant, le voisinage entourant chaque analyse contient souvent des renseignements précieux sur les changements de valeurs des caractéristiques dans la dimension de profondeur du profil CTP et sur la vitesse à laquelle ces valeurs changent. Des changements soudains et rapides des valeurs peuvent être de forts indicateurs de facteurs corrompant les données enregistrées dans les analyses de la CTP. Par conséquent, nous plaçons des fenêtres de différentes tailles autour de chaque analyse de la CTP et calculons des statistiques sur les valeurs de l’analyse dans la fenêtre afin de renforcer chaque analyse avec des renseignements sur des voisinages de différentes tailles. Nos évaluations expérimentales ont montré que ces caractéristiques supplémentaires ont un effet positif sur le rendement du modèle.

L’étape du partitionnement des données est utilisée pour diviser les analyses de la CTP en groupes ayant des propriétés physiques similaires les uns aux autres. Étant donné que les profils CTP sont recueillis dans une vaste zone géographique (le nord-est du Pacifique), sur une vaste étendue de profondeurs (de 0 à 4 300 mètres sous la surface) et pour toutes les saisons, ces variations spatio-temporelles mènent à une distribution très variée des propriétés physiques dans les analyses de la CTP. Ce degré de variation est difficile à gérer pour un seul perceptron multicouche et pour qu’il apprenne à distinguer les analyses de bonne ou de mauvaise qualité dans toutes les conditions observées. Le rendement peut être grandement amélioré en partitionnant d’abord les analyses, puis en entraînant un perceptron multicouche distinct pour chaque partition. Pour ce faire, nous utilisons un modèle de mélange gaussien entraîné aux principales propriétés physiques des analyses, à savoir les valeurs de température, de conductivité et de salinité.

Enfin, la classification des données est réalisée à l’aide d’un perceptron multicouche par groupe d’analyses de la CTP. Le perceptron multicouche est entraîné à la classification binaire pour signaler les analyses de la CTP comme étant de mauvaise qualité (à supprimer) ou de bonne qualité (à conserver). La réalité de terrain utilisée pour produire les données d’entraînement est dérivée des exemples historiques de contrôle de la qualité, en utilisant les décisions prises par les océanographes dans le passé au sujet des analyses à supprimer. Les analyses supprimées sont beaucoup moins nombreuses que les analyses conservées, ce qui rend les données d’entraînement très déséquilibrées. Cela pose souvent un problème dans un contexte d’apprentissage automatique, car cela amène le modèle à apprendre d’une manière qui favorise la classe majoritaire. Pour y remédier, nous appliquons un suréchantillonnage pour dupliquer aléatoirement les analyses supprimées dans les données d’entraînement afin d’équilibrer leurs nombres avec les analyses conservées.

Rendement du modèle expérimental

Afin de valider le rendement du modèle, nous avons effectué une expérimentation à l’aide des données CTP historiques couvrant les années 2013 à 2021. Nous utilisons une méthodologie de validation croisée à cinq volets pour assurer la robustesse des résultats mesurés.

Il est important que le modèle soit en mesure de classer efficacement à la fois les analyses à supprimer et les analyses à conserver, ou dans le contexte de l’apprentissage automatique, les échantillons positifs et négatifs. Bien que le rendement pour la classification des échantillons positifs et négatifs puisse être mesuré séparément, nous avons configuré le modèle de façon à équilibrer le rendement entre ces deux objectifs. Par conséquent, nous ne déclarons ici que l’exactitude globale du modèle par souci de simplicité. L’exactitude globale obtenue par le modèle est d’environ 92,6 % mesurée par rapport aux décisions historiques prises par les océanographes. Cela démontre que le modèle a appris à observer efficacement les schémas indiquant des analyses de mauvaise qualité et à reproduire avec un degré élevé de précision la prise de décision utilisée par les océanographes.

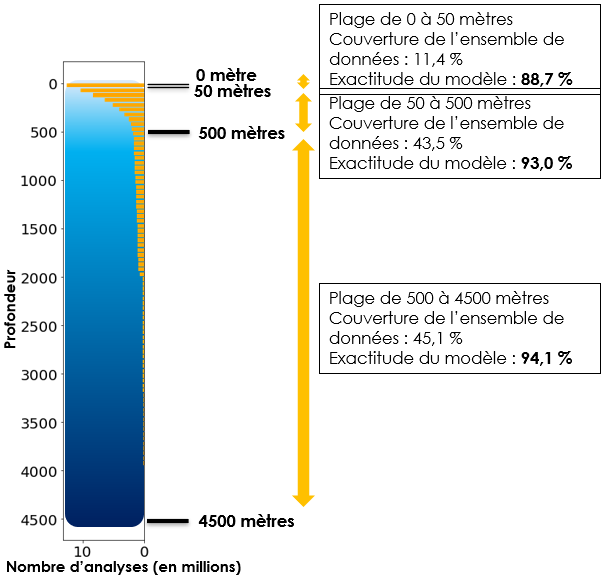

Il est également important de noter que la qualité des indicateurs du modèle est influencée par la profondeur des analyses traitées. Les profondeurs les plus superficielles sont les plus difficiles à gérer, car les plus grandes variations des propriétés physiques de l’eau se produisent près de la surface. La figure de droite présente une ventilation des rendements du modèle par plage de profondeur. Les 50 premiers mètres présentent un défi considérable, ce qui donne une exactitude de modèle d’environ 88,7 %. Les analyses inférieures à 500 mètres sont plus régulières, ce qui donne une exactitude de modèle d’environ 94,1 %.

La précision parfaite du modèle ne sera jamais atteinte, car la prise de décisions est incertaine, même pour les océanographes. De nombreux facteurs complexes entrent en jeu et influencent les données qui sont finalement enregistrées, comme l’eau agitée qui cause la descente irrégulière de l’équipement d’analyse, les vents et les conditions météorologiques violentes qui causent le mélange des eaux près de la surface, et les courants qui causent le mélange des eaux sous la surface. Comme la distinction entre les données d’analyse correctes et corrompues peut être très difficile à repérer dans ces conditions, le processus de prise de décision humaine n’est pas assuré d’être parfait. Cela met en évidence un domaine potentiel où le développement de modèles d’IA plus matures qui peuvent exploiter des renseignements supplémentaires sur ces facteurs pourrait mener à des approches automatisées susceptibles d’éventuellement améliorer la qualité globale des décisions humaines.

Déploiement et intégration du modèle

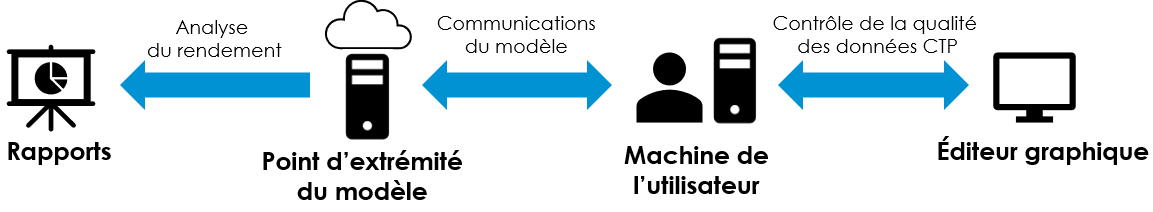

Pour tirer une valeur pratique du modèle d’IA, il faut l’intégrer au processus opérationnel du client d’une manière facile à utiliser. Nous avons adopté une approche consistant à rendre le modèle disponible au moyen d’un point d’extrémité en ligne en temps réel déployé sur une plateforme d’analytique infonuagique. Le client utilise ensuite le modèle en communiquant avec le point d’extrémité géré par un programme côté-client qui fonctionne sur la machine de l’utilisateur.

Pour les paramètres d’essai sur le terrain, nous avons utilisé Azure Databricks comme plateforme d’analytique infonuagique au moyen de laquelle le modèle est déployé. Un point d’extrémité en ligne en temps réel est utilisé pour rendre le modèle disponible au moyen d’une interface de programmation d’application (API). Cela signifie que les utilisateurs authentifiés peuvent accéder au modèle à partir de n’importe quelle machine connectée à Internet. Nous avons produit un programme côté-client léger qui fonctionne sur la machine de l’utilisateur pour gérer la communication avec le modèle. Ce programme fournit une interface graphique simple permettant de sélectionner les fichiers CTP à envoyer au modèle pour traitement. Le programme reçoit ensuite une réponse comportant les indicateurs générés par le modèle et enregistre les nouveaux fichiers contenant les résultats. Ces fichiers peuvent être chargés directement dans l’éditeur graphique utilisé pendant le processus standard de contrôle de la qualité des données CTP. L’utilisateur dispose ainsi d’une méthode simple pour utiliser le modèle avec un minimum de frais généraux et intègre les résultats du modèle directement dans le logiciel de contrôle de la qualité existant.

L’utilisateur peut, en option, renvoyer les fichiers CTP au point d’extrémité du modèle une fois le processus de contrôle de la qualité terminé. Cela permet de comparer les décisions de suppression d’analyses prises par l’utilisateur avec les indicateurs prévus par le modèle afin d’évaluer le rendement du modèle. Les résultats sont ensuite analysés afin de fournir une ventilation du rendement du modèle pour diverses mesures qui sont présentées visuellement dans un rapport Power BI.

Prochaines étapes

Après avoir franchi les étapes de validation de principe et d’essai sur le terrain, le modèle a démontré des résultats positifs qui peuvent générer une valeur opérationnelle en accélérant le processus de contrôle de la qualité des données CTP. Nous sommes maintenant en mesure de commencer les préparatifs pour intégrer le modèle dans un environnement de production. Des améliorations seront apportées au déploiement du modèle, à l’architecture d’intégration et au code de soutien afin de garantir que le client puisse disposer de la fonctionnalité du modèle sous la forme d’un outil solide. Une surveillance doit également être mise en œuvre pour veiller à ce que le modèle continue d’offrir un rendement fiable au fil du temps. Si une dérive du modèle est détectée pendant la surveillance, cela doit déclencher une action corrective pour entraîner le modèle de nouveau. Enfin, un tableau de bord approfondi des rapports sur le modèle sera conçu pour fournir des renseignements détaillés sur le rendement du modèle, ce qui permettra à l’utilisateur de mieux comprendre l’outil avec lequel il travaille.