Important: The GCConnex decommission will not affect GCCollab or GCWiki. Thank you and happy collaborating!

Tendances Technologiques/Informatique en Périphérie

|

|||||||

|---|---|---|---|---|---|---|---|

| |||||||

| Status | Publié | ||||||

| Version originale | 19 juillet 2019 | ||||||

| Mise à jour | 12 février 2020 | ||||||

| Publication officielle | Informatique en Périphérie.pdf | ||||||

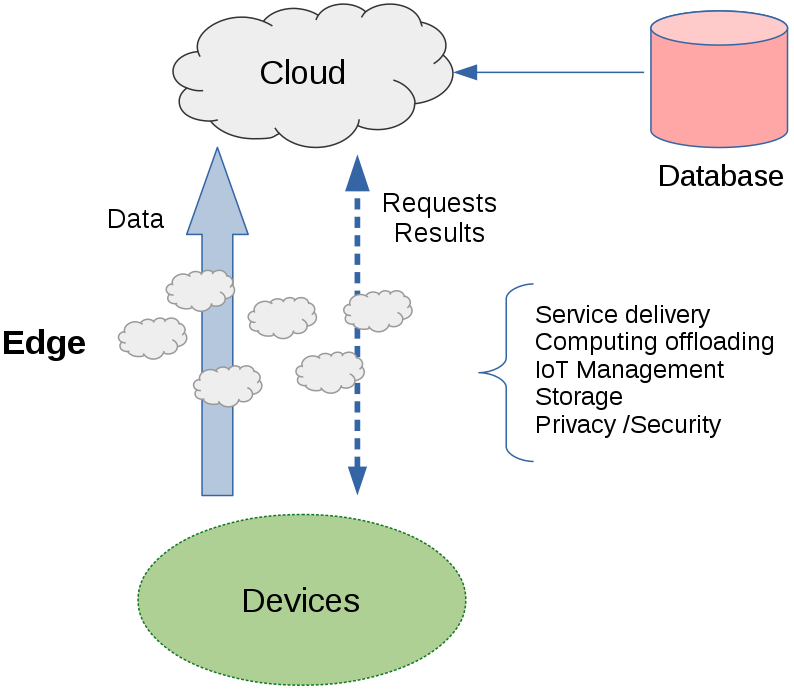

L'Informatique en Périphérie est une architecture informatique distribuée dans laquelle les données sont recueillies, triées, analysées, stockées (à court terme) et traitées à la périphérie du réseau

(c’est-à-dire aussi près que possible de la source de données ou de l’utilisateur d’origine).

L’informatique en périphérie fait partie d’une topologie d’ordinateurs/de réseaux distribuée qui nécessite et comprend un élément central, soit un centre de données ou un service infonuagique centralisé. Les données peuvent être traitées au point d’origine par un dispositif intelligent ou envoyées à un serveur intermédiaire situé à proximité.

Les données pour lesquelles le facteur temps est moins important sont envoyées vers un nuage ou un centre de données pour analyse historique, analyse de mégadonnées et stockage à long terme. Selon Gartner, d’ici 2022, plus de 50 % des données générées par les entreprises seront créées et traitées en dehors du nuage ou du centre de données.[1] L’avènement de l’informatique en périphérie s’explique par la mobilité, la diminution du coût des composants informatiques et le nombre d’appareils en réseau dans l’Internet des objets.[2]

Sommaire opérationnel

La périphérie de l’informatique en périphérie correspond au lieu où les utilisateurs et les objets physiques se connectent et convergent avec le monde numérique.[3]

Il n’y a pas qu’une seule périphérie : la même topologie en possède beaucoup, et les connexions et niveaux hiérarchiques sont aussi nombreux.

Si le système est entièrement autonome et en boucle fermée et qu’il n’interagit pas avec un élément central, ce n’est pas de l’informatique en périphérie, mais plutôt de l’informatique locale. Si un capteur n’est connecté qu’à un ordinateur local (ordinateur personnel, automate programmable, voiture autonome, etc.), le capteur n’est pas en périphérie. C’est au contraire simplement un capteur qui envoie des données à un ordinateur local, avec lequel seuls les utilisateurs locaux peuvent interagir. De même, si une personne interagit avec un appareil (outil de traitement de texte ou outil de création artistique par la réalité virtuelle avec casque d’écoute et ordinateur personnel), on ne parle pas d’informatique en périphérie.

Un appareil en périphérie peut être n’importe quel appareil qui produit des données. Ce peut être des capteurs, des machines industrielles ou d’autres dispositifs qui produisent ou collectent des données et qui font partie intégrante de l’Internet des objets. L’Internet des objets désigne les appareils physiques (aussi appelés appareils « connectés » ou « intelligents ») qui se connectent entre eux à l’aide d’Internet ou par communication directe entre appareils mobiles. Une grande partie des données produites par ces appareils et leurs utilisateurs n’ont pas nécessairement besoin de traitement ou d’analyse en profondeur, car l’interaction qui les unit est souvent singulière et éphémère.

En échange, le délai de traitement des données devrait être court et les résultats devraient arriver vite. Une longue latence (délai), comme c’est généralement le cas sur les réseaux lorsque les données passent par un nuage ou un centre de données, n’est pas souhaitable pour les appareils de l’Internet des objets.

L’informatique en périphérie offre un avantage par rapport aux centres de données traditionnels ou aux nuages dans les cas où la latence, la connectivité, la bande passante ou le coût sont des facteurs cruciaux et où un traitement en temps réel est nécessaire. Le but est de supprimer la latence de traitement, les données n’ayant pas besoin de voyager entre la périphérie et le système central de traitement. En éliminant la distance et le temps d’envoi des données à des sources centralisées, la vitesse de transport des données augmente de même que les performances des appareils et applications en périphérie.

L’informatique en périphérie devrait gagner en popularité au gré des progrès technologiques de l’apprentissage autonome et de l’Internet des objets.[4]

Plusieurs termes associés s’utilisent à la place d’informatique en périphérie. Ce peut être des modes d’implantation ou des types d’informatique en périphérie qui dépendent de topologies particulières, des utilisations prévues ou d’impératifs extérieurs. L’informatique en brouillard, qui étend la capacité infonuagique jusqu’à la périphérie du réseau; l’informatique en nuage multiaccès, qui étend la capacité infonuagique aux réseaux d’accès radio (comme la 5G), et les mini-nuages, essentiellement des nuages portables qui rapprochent le nuage de l’utilisateur et permettent à ce dernier d’utiliser le nuage hors ligne, en sont des exemples.

Sommaire technique

L’informatique en périphérie est une combinaison de matériel et de logiciels (calculs, stockage, mise en réseau, analyse de données, gestion de données, etc.) qui effectuent le traitement de l’information à la source de données ou très près de cette dernière.

Le traitement peut être aussi simple que le filtrage et le stockage des données, ou aussi complexe que l’analyse avancée et l’apprentissage autonome.

Contrairement à l’infrastructure-service dans le nuage, les architectures informatiques en périphérie varient considérablement, en fonction des utilisations. L’un des principaux types d’informatique en périphérie est l’informatique en périphérie mobile, une architecture qui utilise la périphérie du réseau cellulaire pour améliorer les tâches exécutées.

Les données sont traitées à la périphérie, et la totalité ou une partie des données est envoyée au centre de traitement ou au lieu de stockage dans un centre de données, un centre de colocation ou une infrastructure-service dans le nuage.[5] La plupart des données créées et traitées en périphérie ne quitteront jamais cette dernière. L’informatique en périphérie a le vent dans les voiles là où les marchés de l’Internet des objets prennent de l’ampleur; ses utilisations, ses technologies, ses besoins et ses normes et règles de télécommande sont nombreux. Au lieu d’avoir constamment à établir contact avec l’infrastructure infonuagique centrale pour des directives ou une analyse, l’Internet des objets ou les appareils en périphérie peuvent se débrouiller de manière autonome. Une grande partie des données en périphérie devront être traitées en périphérie, exploitées en périphérie et filtrées avant d’être transmises au système central.

Par l’informatique en périphérie, les activités de traitement de données et autres opérations réseau ont lieu loin du système central et des segments toujours connectés et sont acheminées aux points terminaux tels que les portables, les tablettes et les téléphones intelligents. La passerelle en périphérie constitue la mémoire tampon entre le lieu de traitement en périphérie et le réseau général.

L’informatique en périphérie suit divers modes de fonctionnement et contribue à l’architecture informatique de plusieurs moyens. On y a fréquemment recours pour améliorer les réseaux et favoriser l’efficacité et la sûreté des systèmes d’entreprise.

Le nuage public n’a pas d’égal en sa capacité de stockage et de traitement de données. Cependant, lorsque le nuage participe au transport des données, la vitesse de la lumière et la taille des câbles Internet sont des facteurs limitatifs. Dans un contexte d’informatique en périphérie, les données ne sont pas envoyées dans le nuage, elles sont exploitées à la source, ou aussi près que possible de la source, afin de produire l’information en temps réel.

La distance physique augmente la latence de la communication entre l’utilisateur et le nuage. De plus, la vitesse de traitement dépend largement des performances de l’appareil de l’utilisateur.[6]

Les plateformes informatiques en périphérie rendent possible le traitement par certaines applications à l’aide d’un petit serveur situé entre le nuage et l’utilisateur, près de l’appareil. Ainsi, une partie de la charge de travail du nuage ou de l’appareil de l’utilisateur est transférée à un emplacement plus proche de l’utilisateur où les données sont traitées. Les applications qui nécessitent une faible latence prennent ainsi moins de temps à répondre sur l’appareil de l’utilisateur.

Les applications informatiques en périphérie, comme les navigateurs Web, font partie des applications les plus répandues dans les entreprises et chez les utilisateurs particuliers. La majorité des utilisateurs sur ordinateur personnel et appareil mobile font leurs affaires sur Internet à l’aide de navigateurs Web. Les navigateurs Web ont pris leur place dans un nombre toujours plus élevé d’appareils, depuis les décodeurs et les ordinateurs portables jusqu’aux écrans d’affichage numérique. Pourtant, la facilité d’utilisation et la vitesse d’affichage d’un navigateur Web dépendent fortement des performances de l’appareil; ceux à faible capacité éprouvent beaucoup de difficultés à accomplir les tâches. Les nouveaux navigateurs Web peuvent envoyer une partie de la charge de travail à un serveur en périphérie et ainsi constater une nette amélioration partout, de la vitesse d’affichage au téléchargement des données. Les sites Web complexes, tels que ceux utilisant des scripts Java (et du JavaScript complexe) et ceux contenant beaucoup d’images, se téléchargeront plus rapidement (la latence sera réduite). Lorsque le traitement d’un navigateur Web a lieu sur le serveur en périphérie au lieu de l’appareil lui-même, les performances de l’appareil n’ont généralement plus aucune influence sur le résultat final. L’appareil est donc libéré de ses contraintes de traitement et peut effectuer d’autres tâches dont a besoin l’utilisateur.

Utilisation par l'industrie

La quatrième révolution industrielle (Industrie 4.0) se caractérise par une technologie qui brouille la frontière entre le physique et le numérique (systèmes cyberphysiques). L’Internet des objets, un élément important de l’infrastructure numérique, est apparu dans l’Industrie 4.0 comme l’une des technologies fondamentales contribuant à créer l’« usine du futur ». L’Industrie 4.0 transforme le système de production traditionnel en un nouveau modèle appelé « Internet industriel des objets ».

L’Internet industriel des objets comporte l’accès à des données en temps réel qui permettent aux partenaires fabricants et à leurs machines de partager l’information avec précision et rapidité.

L’objectif de l’Industrie 4.0 est de réaliser des gains d’efficacité de production à faible coût et de créer des opérations plus fiables en tirant parti de l’Internet des objets et de l’automatisation.

L’Internet des objets et les technologies immersives sont des technologies à effet de réseau qui accélèrent la mise à l’échelle des activités commerciales numériques par la création de données, d’interactions et d’occasions à saisir ainsi que l’amélioration et l’accélération des décisions.

Toutefois, même dans le cadre d’un modeste projet de l’Industrie 4.0, la quantité de données pourrait être trop importante pour les systèmes existants et nouveaux et faire considérablement monter les coûts de bande passante, de stockage de données, de traitement informatique et de manipulation scientifique des données. Le traitement de la plupart de ces données en périphérie, pour filtrer le bruit, peut faire ressortir l’information la plus importante et faire diminuer considérablement le coût des données.[7]

Dans le contexte de l’Internet industriel des objets, la périphérie fait référence à l’infrastructure informatique à proximité des sources de données, par exemple les machines industrielles (éolienne, appareil d’imagerie par résonance magnétique, etc.), les contrôleurs industriels tels que les systèmes SCADA (Supervisory Control and Data Acquisition) et les bases de données chronologiques regroupant les données provenant de divers équipements et capteurs. Ces appareils en périphérie sont généralement loin des systèmes centraux dans le nuage.[8]

De nos jours, les solutions informatiques en périphérie ont tendance à être hautement personnalisées et destinées à des marchés verticaux. L’arrivée graduelle à maturité de l’informatique en périphérie est telle que des marchés plus standards devraient voir le jour.

Certains de ces marchés seront vastes, d’autres seront spécialisés dans un domaine. Certains auront des solutions différentes qui répondent néanmoins aux mêmes besoins. Certains arriveront à maturité rapidement, d’autres prendront des années, et d’autres encore demeureront au stade actuel. Ce qui fait le succès d’un fournisseur dans un marché d’informatique en périphérie n’a souvent rien à voir avec ce qui fonctionne dans d’autres marchés. En même temps, les marchés qui arrivent à maturité plus rapidement (par exemple, les marchés de consommateurs comme pour la maison intelligente) auront une influence sur les technologies des marchés adjacents.

Le nuage joue toujours un rôle essentiel parce qu’il permet d’atteindre de nouveaux niveaux de performance grâce à l’Internet industriel des objets, où il faut beaucoup de puissance de traitement pour gérer efficacement de vastes volumes de données provenant de machines. Mais à mesure que les capacités de traitement, de stockage et d’analyse sont prises en charge par de petits appareils qui se trouvent plus près de la source de données, à savoir les machines industrielles, l’informatique en périphérie sera essentielle pour que le traitement en périphérie réponde aux standards qu’on attend de l’Internet industriel des objets.[9]

L’informatique en périphérie utilise des ressources dédiées sur place, à même le local de production, et non des serveurs à distance dont dépend le nuage. On augmente ainsi de beaucoup la quantité de données que peuvent traiter les fabricants en temps réel et la vitesse de traitement. Plusieurs parties de la chaîne d’approvisionnement peuvent bénéficier de l’informatique en périphérie. Les deux secteurs principaux sont généralement divisés en deux catégories : la périphérie proche et la périphérie éloignée. La périphérie proche porte sur l’automatisation des processus de fabrication, ou l’utilisation de données d’analyse pour la production, pour surveiller les besoins d’entretien anticipé, l’optimisation des processus et plus encore. La périphérie éloignée dépasse le local de production et relie les fabricants à leurs partenaires commerciaux et même aux consommateurs afin de rendre le service plus proactif, pour les pièces et le service après-vente. Par exemple, si un fournisseur d’équipement lourd vend un produit à la fine pointe de la technologie à une entreprise de construction, le fabricant sera en mesure de déterminer quand la machine devra être entretenue, quelles pièces devront être remplacées et plus encore, avant même que la machine ne tombe en panne.[10]

Bombardier, une entreprise d’aérospatiale, a choisi d’utiliser des capteurs dans ses avions en 2016. Elle a ainsi pu accroître ses revenus grâce à des données en temps réel sur la performance de ses moteurs, ce qui lui a permis de régler les problèmes en amont sans avoir à immobiliser ses avions au sol. Il n’est donc plus nécessaire de renvoyer les données des capteurs de moteur à un serveur central, que ce soit dans l’avion ou dans le nuage, afin de déterminer les problèmes les plus urgents, par exemple si le moteur surchauffe ou si le rapport air-essence est trop pauvre.[11]

Dans le cas des véhicules autonomes, qui sont essentiellement des centres de données sur roues, l’informatique en périphérie joue un rôle prépondérant. Le partenaire de GE Digital, Intel, estime que les voitures autonomes, avec des centaines de capteurs embarqués, généreront 40 téraoctets de données toutes les huit heures de conduite. Il est dangereux, inutile et peu pratique d’envoyer toutes ces données dans le nuage, car bon nombre de mesures et d’interventions doivent être prises et exécutées en temps réel avec une latence ultrafaible pour la sécurité des passagers et du public.

Il serait catastrophique d’utiliser dans les rues et sur les autoroutes une voiture qui envoie des données dans le nuage pour qu’elles soient analysées et qu’une décision soit prise. De plus, si une voiture autonome est embourbée dans une tempête de neige et perd sa connexion Internet, la situation n’est plus problématique, car le traitement et les actions en temps réel de l’informatique en périphérie n’exigent pas l’intervention d’une source externe. Cependant, le nuage reste un élément de premier plan dans l’Internet industriel des objets. Le simple fait que la voiture ait dû réagir à un événement immédiat et spécifique peut devenir une donnée précieuse lorsqu’on la verse parmi l’ensemble des données d’un jumeau numérique et compare le tout aux performances des autres voitures de sa catégorie.[12]

L’informatique en périphérie mobile, ou informatique en périphérie multiaccès, est un concept d’architecture réseau qui procure un environnement informatique à la périphérie du réseau cellulaire. L’idée de base derrière ce type d’informatique est qu’en exécutant les applications et les tâches de traitement connexes plus près du cellulaire client, on réduit la congestion sur le réseau et améliore le fonctionnement des applications.[13] L’informatique en périphérie mobile déplace le traitement du trafic et des services d’un nuage centralisé vers la périphérie du réseau, plus près du client.

Au lieu de faire traiter toutes les données dans un nuage, le système en périphérie analyse, traite et stocke les données. L’informatique en périphérie mobile offre également des capacités infonuagiques et un environnement informatique à la périphérie du réseau.[14] En voici quelques cas d’utilisation typiques : analyse de données et de vidéos, services de localisation, Internet des objets, réalité augmentée et hébergement local de contenu, comme les vidéos. Les principales caractéristiques de l’informatique en périphérie mobile sont la proximité, la latence ultrafaible, la bande passante élevée et la virtualisation.[15]

Répercussions pour les agences gouvernementales

Il y a un manque important d’initiatives et de programmes documentés du gouvernement du Canada qui touchent l’informatique en périphérie. La situation peut s’expliquer par le fait que le gouvernement doit actuellement composer avec la mise en œuvre de services infonuagiques et que la majorité des ressources sont ainsi occupées, ainsi que par les questions de sécurité entourant la protection des renseignements des Canadiens.

D’autres entrevues et recherches devront avoir lieu auprès des directeurs de comptes de SPC et des ministères clients afin de déterminer les capacités actuelles et potentielles du gouvernement du Canada en matière d’informatique en périphérie.

Services partagés Canada (SPC)

Proposition de valeur

L’informatique en périphérie peut permettre au gouvernement du Canada de traiter rapidement de grandes quantités de données là où elles sont recueillies afin d’améliorer la rapidité de la prestation des services et leur utilité pour les Canadiens. Les avantages potentiels de cette technologie seront réalisés en majeure partie aux postes frontaliers, aux aéroports et aux stations météorologiques.

Ce pourrait par exemple être une caméra vidéo effectuant une reconnaissance faciale en temps réel dans un aéroport afin d’alerter les agents des services frontaliers si elle détecte des attitudes ou des comportements suspects.

L’une des principales utilités de l’informatique en périphérie est d’améliorer la sécurité réseau. L’architecture de sécurité est un point névralgique à l’ère de l’Internet des objets, où une diversité de plus en plus grande d’appareils peuvent accéder d’une manière ou d’une autre à un réseau.

Parmi les stratégies possibles pour y faire face, l’informatique en périphérie peut être employée pour colliger les données plus loin et les chiffrer au fur et à mesure qu’elles passent dans le réseau. Si on traite le plus grand nombre de données possible en périphérie au lieu de les envoyer dans le nuage, le risque qu’elles soient interceptées ou trafiquées est beaucoup plus faible. En employant de bons systèmes informatiques en périphérie, les entreprises pourront conserver la majeure partie des systèmes informatiques et des systèmes technologiques opérationnels dans des zones sécurisées des réseaux.[16] Grâce à l’informatique en périphérie, les professionnels de l’informatique espèrent améliorer l’efficacité des réseaux, notamment sur le plan de la sécurité.

L’informatique en périphérie peut également réduire la distance que doivent parcourir les données dans un réseau ou faciliter la création d’un modèle détaillé de virtualisation du réseau.[17] Dans certains cas, les besoins en latence et en capacité de traitement peuvent être comblés par des interactions avec un système central, soit un fournisseur d’infonuagique ou un centre de données. Cependant, à mesure que les entreprises numériques veulent saisir des occasions et augmenter leurs interactions en temps réel, les activités de traitement et de stockage devront être physiquement situées plus près des gens et des objets.

L’envoi de données à un centre de données sur le nuage à distance pour analyse accentue la latence, voire la rend imprévisible. Il pourrait vite être trop tard dans les situations particulièrement urgentes. L’informatique en périphérie offre une latence prévisible et ultrafaible, idéale lorsque le temps est un facteur, y compris dans tous les cas où la tâche est essentielle à la mission ou que les objets sont en mouvement. Les véhicules en marche, les machines, les pièces, les personnes et les fluides sont des exemples de situations où les retards peuvent entraîner des occasions manquées, des coûts élevés ou des menaces à la sécurité.

Les déploiements en périphérie conviennent à une variété de circonstances. C’est le cas lorsque les appareils de l’Internet des objets ont une mauvaise connexion et que la connexion constante des appareils de l’Internet des objets au nuage central n’est pas une option efficace. C’est aussi le cas lorsqu’il faut traiter de l’information sans trop de latence. C’est idéal pour les situations où les latences de quelques millisecondes sont déjà trop longues, par exemple dans les services financiers ou la fabrication.

Il y a, cependant, plusieurs facteurs clés qui font de l’informatique en périphérie une réalité plus viable aujourd’hui. Le coût des ordinateurs et des capteurs continue de chuter, la taille des appareils puissants est de plus en plus petite (passerelle ou concentrateur de capteurs), on constate une croissance exponentielle du volume de données provenant de machines et de l’environnement (conditions météorologiques ou valeur marchande) et l’apprentissage autonome et les capacités d’analyse se perfectionnent.[18]

Difficultés

Il y a cinq impératifs qui braquent de plus en plus les projecteurs sur la périphérie : latence/déterminisme (de la microseconde à la sous-seconde, constance); données/bande passante (massive ou modérée, valeur locale ou valeur agrégée); autonomie limitée (autonomie occasionnelle ou totale, auto-organisation et découverte); confidentialité/sécurité (privée/sensible ou publique, réglementée/géospécifique ou non) et interaction locale (collaboration ou adaptation locale, horizontale ou verticale). La principale difficulté pour les organisations sera d’évaluer leurs réseaux et de déterminer quand et comment appliquer l’informatique en périphérie afin d’accroître l’efficacité et d’améliorer la prestation des services. La latence sera un facteur (en particulier dans les situations où c’est essentiel à la mission et à la sécurité) : ainsi, une partie du traitement devra se faire à proximité. Encore une fois, la difficulté est de cerner les éléments essentiels à la mission sur le réseau et de leur donner un accès prioritaire aux systèmes en périphérie.

L’informatique en périphérie ne sera pas un marché unique dominé par un seul fournisseur; il y aura de nombreux types de systèmes périphériques et de nombreux marchés avec leurs architectures, leurs topologies et leurs fournisseurs propres.

Les organisations ont la lourde tâche de déterminer quelle partie du marché de l’informatique de pointe exploiter. Les capacités de bande passante ne devraient pas croître à la même vitesse que les données provenant de l’Internet des objets et des appareils en périphérie, et les coûts de la bande passante ne diminueront pas non plus de manière exponentielle. Ce sera ardu pour la haute direction de choisir les applications et les services qui bénéficieront de l’informatique en périphérie et de ceux qui devront composer avec une latence supérieure.

Il y a aussi le risque que les organisations effectuent trop de traitement de données en périphérie. Il est facile de dépasser la capacité des petits processeurs et des plateformes de stockage en périphérie ou tout près. Dans certains cas, le stockage peut être limité à quelques gigaoctets et traité avec une seule unité centrale. Les limites dépendent des restrictions de puissance et de taille.[19]

Il est fréquent aussi qu’on oublie d’intégrer le volet de sécurité, du concept initial à la production. La sécurité fait partie intégrante des architectures informatiques en périphérie et en brouillard et du traitement centralisé. Elle doit s’appliquer à ces deux éléments et prendre la forme de mécanismes tels que la gestion des identités et des accès. Le chiffrement n’est pas quelque chose d’agréable, mais c’est une nécessité pour des questions de sécurité sur les appareils. Imaginez qu’on pirate un moteur d’avion en plein vol![20]

En outre, si l’interopérabilité et les normes sont importantes pour le développement des marchés, les marchés de l’informatique en périphérie n’auront en revanche pas tous les mêmes normes et exigences d’interopérabilité.

Considérations

Avec le déploiement de l’informatique en périphérie sur les appareils de l’Internet des objets, SPC devra examiner l’incidence sur les besoins informatiques des centres de données finaux une fois que ces appareils commenceront à traiter l’information localement. Alors que de plus en plus de données sont traitées sur les appareils de l’Internet des objets, on s’attend à une réduction considérable des besoins informatiques dans les centres de données finaux. SPC devra également évaluer les répercussions en matière de sécurité et de protection des renseignements personnels de l’utilisation locale des données informatiques sur les appareils de l’Internet des objets situés à l’extérieur de ses centres de données.

SPC devra envisager des plans d’action qui préparent le réseau aux perturbations que pourraient connaître les fournisseurs en créant une stratégie de sortie ou de remplacement des systèmes informatiques en périphérie. Selon Gartner, plus de 80 % des déploiements de systèmes informatiques en périphérie non intégrés mis en œuvre en 2018 et 2019 seront remplacés par de nouvelles technologies matérielles et logicielles d’ici 2022.[21]

SPC devrait également veiller à intégrer un volet d’informatique en périphérie à toutes les stratégies d’infrastructure futures. Les besoins en stockage et en informatique en périphérie dépendront des besoins en matière d’Internet des objets. Au premier bout du spectre, un centre de données central suffira pour le traitement et le stockage. À l’autre bout, le traitement et le stockage devront se faire à la source de données. Cependant, le choix ne manquera pas tout au long du spectre, que ce soit pour la latence, la bande passante, la connexion au système central, l’autonomie, la sécurité, la confidentialité ou les exigences réglementaires, par exemple. Il peut être impertinent, voire techniquement impossible, d’implanter l’informatique en périphérie. SPC devra se doter d’un plan pour gérer les besoins futurs en matière d’infrastructure et de réseau.

SPC devrait envisager de cibler tout processus connecté à un appareil ou capteur de l’Internet des objets capable de gérer de petites quantités de données et de traitement pour voir si l’informatique en périphérie pourrait lui être avantageuse. Environ 90 % de la plupart des traitements liés à l’Internet des objets seront assumés par les processus en périphérie, et les besoins en données et en calculs sont généralement faibles.[22]

SPC pourrait envisager de mettre en place des niveaux de traitement, soit les lieux de traitement en profondeur et de stockage des données dans le système central et les lieux stratégiques de traitement local qui ne demandent pas autant de puissance en périphérie. Le placement local des ressources devient impératif lorsque l’Internet des objets entre en jeu. Pour les implantations d’importance liées à l’Internet des objets, l’analyse doit pouvoir se faire à proximité. Le traitement de données sur une grande distance ne sera tout simplement pas possible lorsqu’il faut intervenir quasi instantanément.[23]

Il est très important que les cadres supérieurs et les employés de SPC sachent que l’informatique en périphérie et l’infonuagique centralisée sont complémentaires. L’informatique en périphérie n’est pas en concurrence directe avec l’infonuagique, c’est plutôt un complément, qui fait en sorte que le nuage demeure en mesure d’effectuer le travail d’analyse en profondeur et de stockage des données. SPC aurait intérêt à collaborer avec les diverses entités et les clients pour comprendre les besoins actuels et futurs en matière d’infrastructure en périphérie et pour élaborer conjointement une stratégie d’informatique en périphérie pour que les services nécessaires continuent d’être offerts.

Les systèmes en périphérie se développeront de manière dynamique dans les entreprises et les locaux commerciaux, se multiplieront sous l’effet des fournisseurs et des opérateurs d’infonuagique et en viendront à dépasser la simple empreinte des téléphones intelligents, des électroménagers, des consoles de jeux, des haut-parleurs intelligents et des passerelles. SPC devrait être conscient de ces structures créées dans un tout organisé en périphérie et les exploiter pour augmenter l’efficacité du réseau et réaliser des économies. Il y aura de nombreux systèmes en périphérie et de nombreuses façons d’assurer les services en périphérie selon l’endroit; il faudra faire preuve d’agilité pour saisir les occasions qui se présentent. Les entreprises devront choisir en fonction des utilisations escomptées; en fait, une entreprise typique comptera bien des formes d’informatique en périphérie.

La plupart des entreprises auront besoin de compétences à la fois pour développer et gérer leurs propres capacités d’informatique en périphérie et pour exploiter les capacités en périphérie de tiers à mesure qu’elles voient le jour. SPC devra déterminer les compétences que devront avoir ses employés pour réaliser les travaux propres à l’informatique en périphérie et arrimer les stratégies d’approvisionnement pour l’informatique en périphérie (sources publiques ou privées) aux cas réels d’utilisation en évaluant les exigences de confidentialité, sécurité et respect de la réglementation ainsi que la maturité des offres publiques d’informatique en périphérie.

Références

- ↑ Bittman, T., Gill, B., & Markkanen, A. (23 août 2018).How Edge Computing Redefines Infrastructure. Récupéré de gartner.com

- ↑ Rouse, M. (22 août 2016). edge computing. Récupéré de searchdatacenter.techtarget.com

- ↑ Bittman, T. (14 février 2018).Digital Business Will Push Infrastructures to the Edge. Récupéré de from gartner.com

- ↑ Gardner, C., Kindness, A., O'Donnell, G., Hopkins, B., Mu, D., Pelino, M., Lynch, D. (5 décembre 2018).Edge Computing Will Radically Alter Your Infrastructure Strategy. Récupéré de forrester.com

- ↑ Butler, B. (21 septembre 2017).What is edge computing and how it’s changing the network. Récupéré de networkworld.com

- ↑ NTT SCL. (13 juin 2016).Edge Computing Platform. Récupéré de youtube.com

- ↑ Appelquist, G. (19 juillet 2019).4.0 Reasons Why Edge Computing is Relevant for Industry 4.0. Récupéré de iiot-world.com

- ↑ GE Digital. (19 juillet 2019).What is Edge Computing? Récupéré de from ge.com

- ↑ GE Digital. (19 juillet 2019).What is Edge Computing? Récupéré de ge.com

- ↑ Fryer, J. (18 décembre 2018).Edge Computing as it Relates to the Manufacturing Industry. Récupéré de manufacturingtomorrow.com

- ↑ Linthicum, D. (19 juillet 2019).Edge computing vs. fog computing: Definitions and enterprise uses. Récupéré de cisco.com

- ↑ GE Digital. (19 juillet 2019).What is Edge Computing? Récupéré de ge.com

- ↑ GE Digital. (19 juillet 2019).What is Edge Computing? Récupéré de ge.com

- ↑ Juniper Networks. (19 juillet 2019).What is Multi-Access Edge Computing? Récupéré de juniper.net

- ↑ Juniper Networks. (19 juillet 2019).What is Multi-Access Edge Computing? Récupéré de juniper.net

- ↑ Appelquist, G. (19 juillet 2019).4.0 Reasons Why Edge Computing is Relevant for Industry 4.0. Récupéré de iiot-world.com

- ↑ Techopedia. (19 juillet 2019).Edge Computing. Récupéré de techopedia

- ↑ GE Digital. (19 juillet 2019).What is Edge Computing? Récupéré de ge.com

- ↑ Linthicum, D. (19 juillet 2019).Edge computing vs. fog computing: Definitions and enterprise uses. Récupéré de cisco.com

- ↑ Linthicum, D. (19 juillet 2019).Edge computing vs. fog computing: Definitions and enterprise uses. Récupéré de cisco.com

- ↑ Bittman, T., & Gill, B. (28 juin 2018).The Future Shape of Edge Computing: Five Imperatives. Récupéré de gartner.com

- ↑ Linthicum, D. (19 juillet 2019).Edge computing vs. fog computing: Definitions and enterprise uses. Récupéré de cisco.com

- ↑ Sweeney, P. (19 juillet 2019).An edge computing architecture upends the data center. Récupéré de searchdatacenter.techtarget.com